Ultimative Anleitung zur Behebung des Fehlers "Googlebot kann nicht auf CSS- und JS-Dateien zugreifen" in WordPress

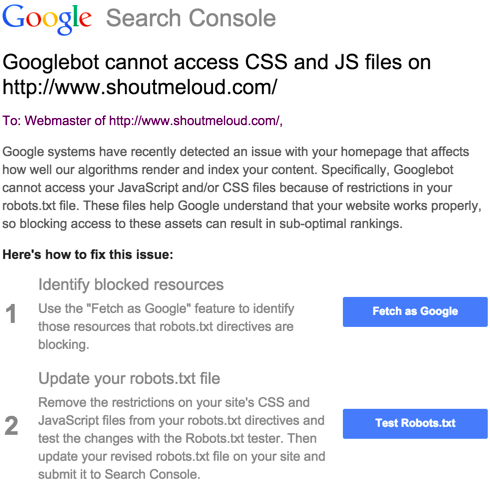

Wenn Sie über Googlebot stolpern, der durch robots.txt in WordPress blockiert wird, dann sind Sie hier genau richtig.

Egal, ob Sie ein WordPress-Entwickler oder ein absoluter Anfänger sind, wir alle hatten schon einmal mit Googlebot-Fehlern zu kämpfen. Diese können ärgerlich sein, weil sie die Sichtbarkeit Ihrer Website in der Google-Suche beeinträchtigen.

Dieser Artikel beschreibt, wie man den Fehler "Googlebot kann nicht auf CSS- und JS-Dateien zugreifen" für WordPress-Seiten behebt.

Fangen wir an!

Warum braucht Googlebot Zugriff auf CSS- und JS-Dateien?

Der beste Weg, eine Frage zu beantworten, ist immer, die Antwort zu verstehen.

Google bevorzugt Websites, die nutzerfreundlich sind: Websites, die schnell laden, ein gutes Nutzererlebnis bieten usw. Um die Nutzerfreundlichkeit einer Website zu ermitteln, benötigt Google Zugriff auf die CSS- und JavaScript-Dateien der Website.

Die Standardeinstellungen von WordPress verhindern nicht, dass Suchbots auf CSS- oder JS-Dateien zugreifen können. Einige Website-Besitzer können jedoch Suchbots blockieren, nachdem sie zusätzliche Sicherheitsmaßnahmen, wie z. B. ein Sicherheits-Plugin, hinzugefügt haben.

Was hat es mit WordPress Robots.txt auf sich?

Bevor wir uns mit den Lösungen befassen, sollten wir verstehen, was die robots.txt Datei tut.

Diese Datei wirkt wie ein Verkehrspolizist für Googlebot und andere Suchmaschinen, der ihnen sagt, was sie crawlen sollen und was nicht.

Standardmäßig erzeugt WordPress eine virtuelle robots.txt Datei, das funktioniert einwandfrei. Allerdings können Sicherheits-Plugins manchmal Zeilen hinzufügen wie Disallow: /wp-includes/was zu diesem Fehler führt.

Die robots.txt Datei in WordPress befindet sich im Stammverzeichnis Ihrer Website, und Sie können über FTP oder Ihr Hosting-Kontrollpanel darauf zugreifen.

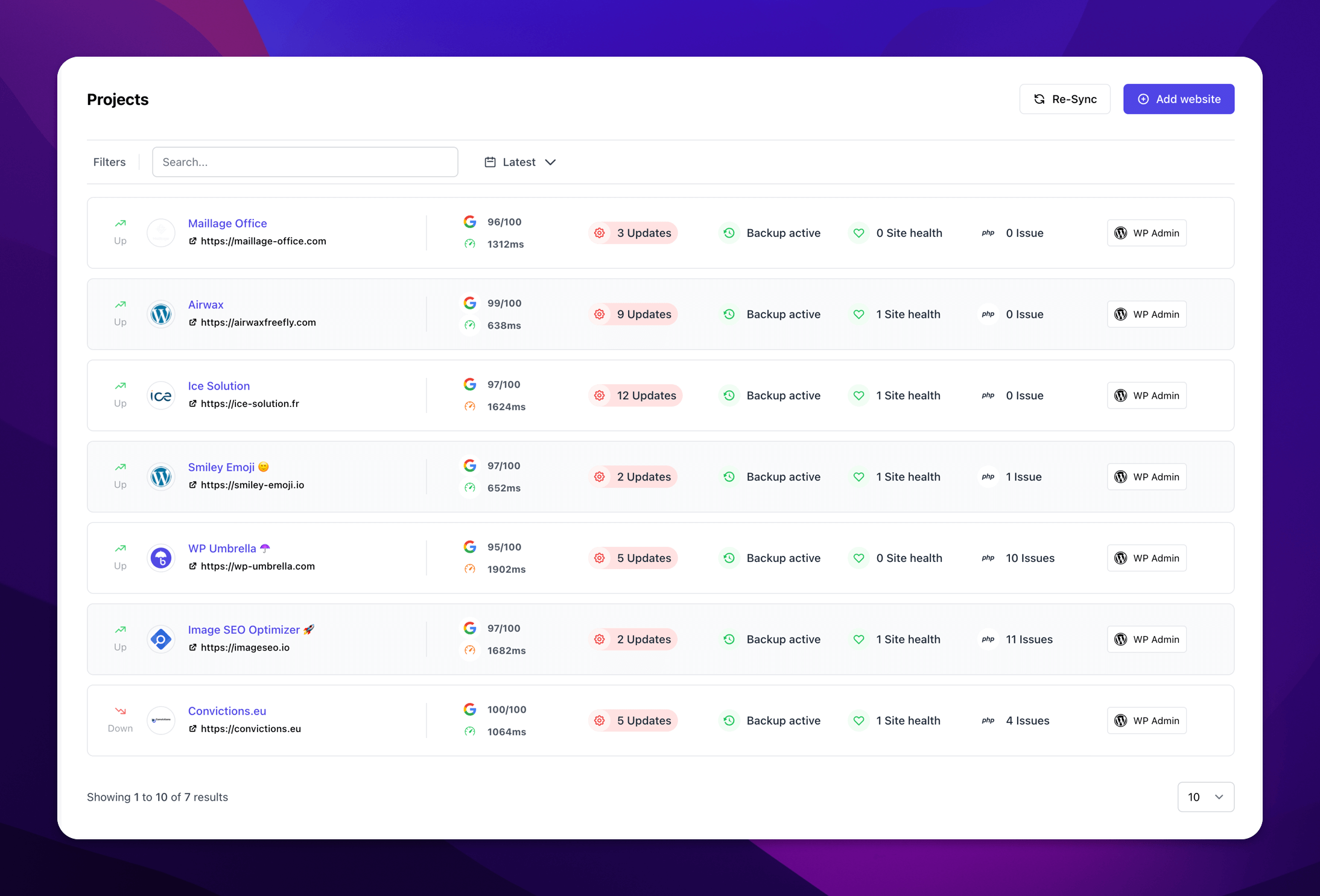

Sind Sie bereit, Ihre Produktivität zu steigern, Ihre Kunden zu beeindrucken und Ihre WordPress-Agentur auszubauen?

Installieren Sie WP Umbrella in einer Minute auf Ihren Websites und entdecken Sie eine neue Art, mehrere WordPress-Sites zu verwalten.

Jetzt kostenlos loslegen

Andere häufige WordPress-Fehler, auf die Sie achten sollten

Wenn Sie schon dabei sind, sollten Sie auch nach anderen häufigen WordPress-Fehlern suchen, wie z. B. dem Fehler "Missing a Temporary Folder". Auch dazu haben wir eine vollständige Anleitung!

Fehlersuche: Behebung des Fehlers "Googlebot hat keinen Zugriff auf CSS- und JS-Dateien" in WordPress

Option 1: Manuelle Bearbeitung der WordPress-Datei Robots.txt

Wie man robots.txt für Googlebot bearbeitet:

Ihre robots.txt-Datei sollte eine Sitemap und einige andere Elemente enthalten, wenn Sie den Fehler beheben möchten, dass Googlebot nicht auf CSS- und JS-Dateien zugreifen kann.

Die Robots.txt-Datei von WordPress ist leicht zu verstehen.

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Allow: /wp-includes/js/Nicht zulassen: /folder bedeutet, dass der Ordner nicht von Googlebot gecrawlt wird.

Erlauben: /folder bedeutet, dass der Ordner von Googlebot gecrawlt wird.

Um den Fehler "Googlebot kann nicht auf CSS- und JS-Dateien zugreifen" in WordPress zu beheben, müssen Sie Googlebot erlauben, den Ordner zu crawlen, in dem Ihre CSS- und JS-Dateien gespeichert sind.

In den meisten Fällen wird das Problem durch Entfernen der folgenden Zeile behoben: Disallow: /wp-includes/

Speichern Sie anschließend Ihre robots.txt-Datei und laden Sie sie hoch. Klicken Sie dann im Google-Tool auf "Abrufen und Rendern". Vergleichen Sie nun die Abrufergebnisse, und Sie sollten sehen, dass viele blockierte Ressourcen nicht mehr blockiert werden.

Tipps

Wenn Sie Ihr robots.txt Datei leer oder nicht vorhanden ist, machen Sie sich keine Sorgen! Googlebot crawlt und indiziert automatisch alle Dateien wenn dies geschieht.

Option 2: Verwenden Sie ein Plugin zur Bearbeitung der Datei Robots.txt

Sie können Ihre robots.txt-Datei auch mit Yoast, SEOPress oder Rankmath bearbeiten. Jedes Plugin hat eine einfache Schnittstelle, mit der Sie die Zeile entfernen können, die Googlebot blockiert.

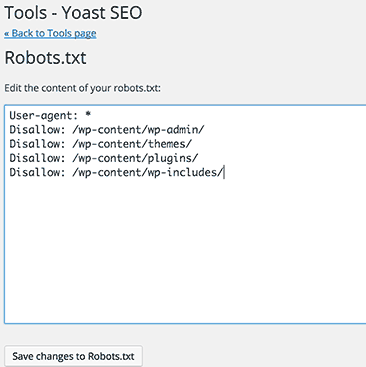

Bearbeiten Sie Ihre robots.txt-Datei mit Yoast

Es ist viel einfacher, eine robots.txt-Datei mit Yoast SEO zu erstellen oder zu bearbeiten. Führen Sie dazu die folgenden Schritte aus.

Schritt 1: Gehen Sie zu Ihrer WordPress-Website und melden Sie sich an.

Sobald Sie angemeldet sind, erscheint Ihr Konto in Ihrem "Dashboard".

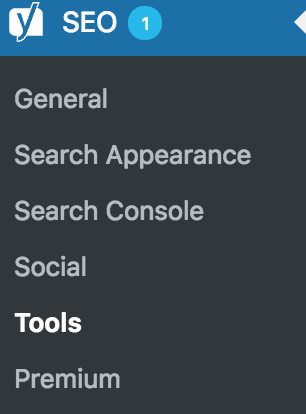

Schritt 2: Klicken Sie auf die Registerkarte "SEO".

Auf der linken Seite des Bildschirms befindet sich eine Suchleiste. Wählen Sie "SEO" aus diesem Menü.

Schritt 3: Klicken Sie dann auf "Werkzeuge".

Weitere Optionen finden Sie in den SEO-Einstellungen. Klicken Sie auf 'Tools'.

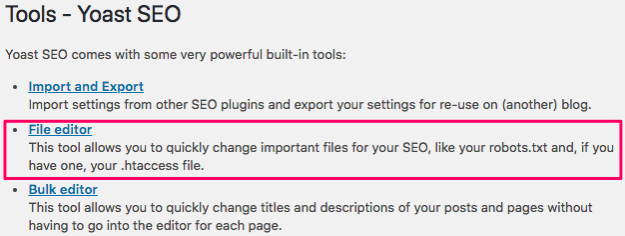

Schritt 4: Klicken Sie auf "Datei-Editor".

Und das war's, Sie müssen nur noch die Zeile "Disallow: /wp-includes/" entfernen und auf "Änderungen an der robots.txt speichern" klicken.

Bearbeiten Sie Ihre robots.txt-Datei mit SEOPress

Schritt 1: Gehen Sie auf die Registerkarte SEO.

Schritt 2: Aktivieren Sie das grüne Optionsfeld, das mit Robotern verbunden ist.

Schritt 3: Aktivieren Sie die virtuelle Datei robots.txt, indem Sie auf Verwalten klicken.

Schritt 4: Schreiben Sie Ihre robots.txt-Datei in Virtual Robots.txt und speichern Sie.

Stellen Sie sicher, dass Sie die Zeile "Disallow: /wp-includes/"

Wenn Sie Ihre robots.txt-Datei sehen möchten, klicken Sie auf Ihre robots.txt anzeigen oder gehen Sie zu 'yoursite.com/robots.txt'.

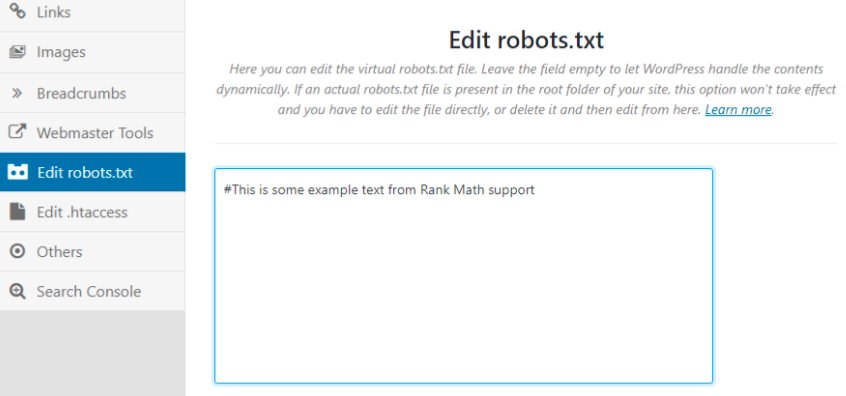

robots.txt mit Rankmath bearbeiten

Auf Rankmath kann die Datei robots.txt wie unten dargestellt bearbeitet werden:

Entfernen Sie noch einmal die Zeile "Disallow: /wp-includes/"

Und das war's!

Was ist, wenn ich JavaScript in WordPress aktivieren möchte?

Wenn Sie JavaScript in WordPress aktivieren möchten, wird es in der Regel nicht durch die robots.txt-Datei blockiert, aber Sie müssen möglicherweise in die Einstellungen Ihres Themes eingreifen oder ein Plugin verwenden, um Skripte effizient hinzuzufügen.

Zusammenfassung: Googlebot-Probleme & SEO-Optimierung

Jetzt sind Sie gut gerüstet, um Googlebot-Probleme wie ein Profi anzugehen! Ganz gleich, ob Sie sich für die manuelle Bearbeitung Ihrer robots.txt oder ein Plugin wie Yoast SEO, SEOPress oder Rankmath verwenden, haben Sie einen entscheidenden Schritt zur Optimierung Ihrer WordPress-Website für Suchmaschinen getan.

Denken Sie daran, dass es einige Zeit dauern kann, bis Google Ihre Website neu gecrawlt hat und die Änderungen berücksichtigt.

FAQs zu Googlebot und WordPress

Dies geschieht in der Regel durch bestimmte Zeilen in der robots.txt-Datei, die den Googlebot daran hindern, bestimmte Teile Ihrer Website zu crawlen.

Ja, die Meldung ist ein zuverlässiger Indikator dafür, dass Googlebot beim Crawlen Ihrer Website auf Probleme gestoßen ist.

In der Regel dauert es ein paar Tage bis Wochen, bis Google Ihre Website erneut gecrawlt und den Index aktualisiert hat.